2023年5月13日にOpenAIの公式から発表された「ChatGPT」の最新バージョン、ChatGPT-4oは、従来のGPT-4が誇る強力な推論能力を”o”「Omni(=ラテン語で『すべての、あらゆる』という意味を持つ言葉」を冠するほどまでに包括的で統合された生成AIとしてアップデートされたモデルです。

2022年にリリースされたGPT-3.5では簡単なテキスト出力に限られたChatGPTの能力は、今や見たものに対して人間と変わらない認識を示し、それについて非ネイティブではAIと判別がつかないほどの流暢な英語で解説するばかりか、人間からの質問にも聡明に答え、画像どころか動画までをも一瞬で生成してしまうほどになりました。

この記事では、また一歩人間に近づいたOpenAIの自然言語処理AI、「ChatGPT-4o」について解説します。

この記事でわかること

目次

ChatGPT-4oは、OpenAIが開発した最新の大規模言語モデル(LLM)であり、「Omni」の名称が示す通り、あらゆる情報を包括的に理解・処理できるマルチモーダルAIです。

従来のテキストだけでなく、画像や音声などの複数の入力形式(モダリティ)を組み合わせることで、より人間に近い認識能力と応答生成能力が実現されています。

人間は、視覚、聴覚、触覚、味覚、嗅覚といった五感を駆使して世界を認識し、情報を処理しています。マルチモーダルAIは、この人間の能力を模倣し、複数のモダリティを統合的に扱うことで、より高度なタスクをこなすことを目指しています。

例えば、画像に写っている物体を認識し、その説明文を生成したり、音声の質問に対して適切な回答を返したり、さらにはテキストと画像を組み合わせて、より複雑な質問に答えることも可能です。

この章の結論:

ChatGPT-4oは主要AIツール中、テキスト処理、画像処理、音声処理の性能がNo.1

| GPT-3.5 | GPT-4 | GPT-4o | |

| トレーニングデータ | ★☆☆ (2021年9月まで) |

★★☆ (2021年9月以降も含む) |

★★★ (最新情報まで含む) |

| 自然言語処理 | ★★☆ (“AI感”ある) |

★★☆ (“AI感”ある) |

★★★ (ほぼ人間、外国語なら気づかない) |

| 精度 | ★☆☆ (デタラメだらけ) |

★★☆ (人間なら博識レベル) |

★★★ (ネット検索に並ぶ) |

| 専門的な質問への解答 | ☆☆☆ (不向き) |

★☆☆ (重要な質問は避けるべき) |

★★☆ (まだ信頼はできない) |

| メタ認知 (広範な文脈への理解) |

☆☆☆ (すぐに前の文脈は忘れる) |

★★☆ (比較的長い会話でも文脈は把握できる) |

★★☆ (比較的長い会話でも文脈は把握できる) |

| MMLU (%) | Massive Multitask Language Understandingの略で、57のタスクからなる大規模な言語理解ベンチマークです。モデルの一般的な知識や問題解決能力を評価します。 |

| GPQA (%) | Grade Point Question Answeringの略で、高校レベルの科学、数学、英語、社会などの科目の質問に対する回答能力を評価します。 |

| MATH (% | 数学的な問題を解く能力を評価します。 |

| HumanEval (%) | プログラミングのコード生成能力を評価します。 |

| MGSM (%) | Massive Graded Semantic Matchingの略で、意味的に類似した文をペアにする能力を評価します。 |

| DROP (F1) | Discrete Reasoning Over Paragraphsの略で、文章から情報を抽出し、推論する能力を評価します。F1スコアは、適合率と再現率の調和平均で、モデルの精度を総合的に示します。 |

一番左軸にあるピンクの棒がGPT-4oは、生成AIの元祖とも言えるテキスト生成能力では安定的に好成績を収めているようです。

ただ、他ツールもGPT-4oに迫る性能を示しており、生成AIが熾烈な開発競争のさなかにあることが伺えます。

音声を聞いてその場で別の言語に翻訳する「Audio translation」は、単に音声文字起こしの精度だけでなく、それを自然な形で別の言語に翻訳するための文脈理解力も必要な高度な技術です。

このAudio translationでもChatGPT-4oはGoogleのGeminiを上回り、主要マルチモーダル生成AIでトップに君臨しています。

|

MMLU |

言語モデルの多様なタスクに対する理解度を測るベンチマークです。 |

| MathVista | 数学の問題を解く能力を評価します。 |

| AI2D | 複雑な推論と問題解決能力を必要とする質問に回答する能力を評価します。 |

| ChartQA | チャートやグラフから情報を抽出する能力を評価します。 |

| DocVQA: | 文書内の画像に関する質問に回答する能力を評価します。 |

| ActivityNet | 動画の内容を理解し、質問に回答する能力を評価します。 |

| EgoSchema | ビデオ内の自己中心的な視点からの質問に答える能力を評価します。 |

テキスト・音声に続いてChatGPT-4oは「視覚認知能力」でも主要ツールを上回る成績を残しており、現状一般公開されている中で名実共に「人間に最も近いAI」になっています。

ここまでは、ChatGPT-4oが前モデルと比較して大幅にアップデートされたことについて解説してきましたが、この章では、具体的にどの機能がどのように改善され、またどのような機能が新しく使えるようになったのかを解説していきます。

以前からGPT-4には音声入力・出力機能がありましたが、今回の4oへのアップデートで音声出入力の精度が大幅に向上しました。

以前の音声出入力では、ChatGPTに限らず多くの音声入力ソフトがそうであるようにノイズを多く拾ってしまったり、実際に喋った言葉とは違う言葉が入力されてしまったり、実用性の面で少し難がありましたが、GPT-4oではバッグにノイズがあったり、複数人で話している場合でも正確に人の声を認識できるようになっています。

また、単語を聞き取るだけでなく、感情やトーンまで分析ができるようになっています。

加えて、以前の音声出力では入力から出力まで4秒~6秒ほどのラグがありましたが、今回のアップデートではラグが半減し、人間同士の会話の平均的な間である2秒以下での出力も急増しています。

これにより、さすがに日本語ではまだAIと話している感覚が残りますが、筆者の第二言語である英語では相手が人なのか、ChatGPTなのかがほとんど判別できないまでのクオリティになっています。

いままでのAIでの画像生成といえば、英語で長大なプロンプトを入力して、細かく指示を出すというプロセスを何度も繰り返す・・・というのが普通でしたが、ChatGPT-4oに搭載されている画像生成機能(DALLE-3)では、下記の公式サンプルのように、プロンプトにも画像を含めることができるのです。

これにより、サンプルにあるような高度なコラージュの作成はもちろん、既存のロゴのフォントを少し変えたり、すでに完成したポスターをイメージアップしたりといったデザイナーズタスクが大幅に効率化されます。

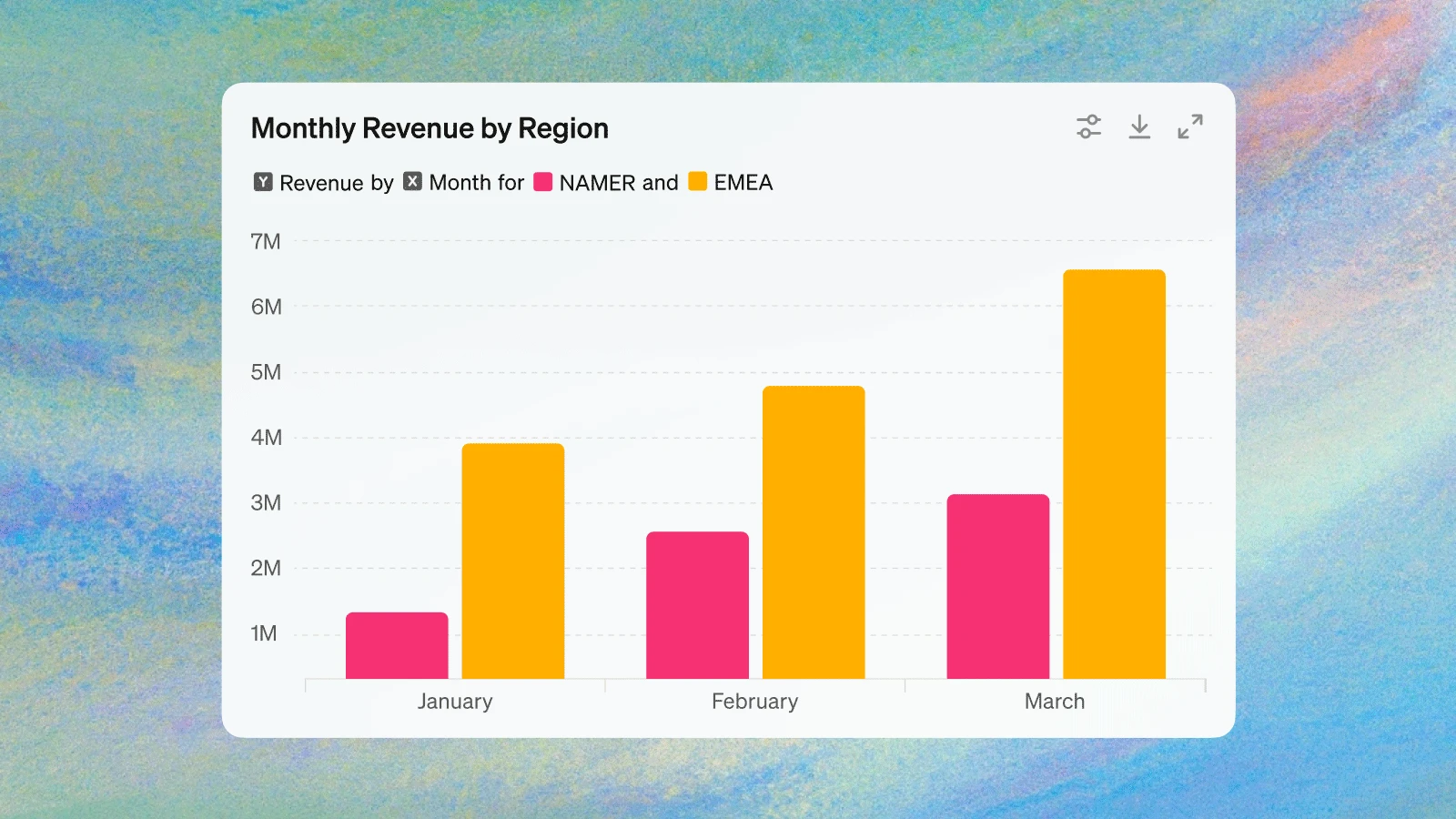

ChatGPT-4oでは、新たに連携したGoogle ドライブやMicrosoftOneDriveから直接ファイルをアップロードできるようになり、いままで以上に直感的な「数字からヴィジュアルへ」が実現しています。

ChatGPT-4oでは、新たに連携したGoogle ドライブやMicrosoftOneDriveから直接ファイルをアップロードできるようになり、いままで以上に直感的な「数字からヴィジュアルへ」が実現しています。

例えば、各月にかかった経費をまとめたExcelをそのままChatGPT-4oに投げるだけで、それを折れ線グラフにして視覚化されてものがアウトプットされるのです。

また、実際に企業で活用がしやすいように、それらの機能でアップロードされたファイルは一切ChatGPTの学習に利用されないなどのセキュリティ面での配慮も行われているのが特徴です。

香川県三豊市は、生成AI「ChatGPT」を利用したごみ出し案内システムを開発し、2024年6月1日から実証試験を開始します。

東京大学大学院の松尾豊教授の研究室と連携して実現されたこのシステムは、スマートフォンなどで音声を使ってごみ出し方法を尋ねると、画面上で回答が表示されます。すでに50カ国以上の言語に対応し、夜間や外国人からの問い合わせにも対応できるため、行政の効率化とサービス向上に寄与します。

試験期間は3カ月から半年程度の予定ですが、市長は期間を限定せずに実施して性能向上を図る考えです。松尾教授は、身近な活用事例から生成AIの普及が進むことを期待しているとのことです。

伊藤忠商事:ChatGPT等の生成AIを用いた企業の業務変革や新規ビジネス開発支援を行う「生成AI研究ラボ」の設立について

伊藤忠商事:ChatGPT等の生成AIを用いた企業の業務変革や新規ビジネス開発支援を行う「生成AI研究ラボ」の設立について

伊藤忠商事は、6月から社内業務に生成AI「ChatGPT」を導入しているようです。専門組織「生成AI研究ラボ」を子会社のブレインパッドと共同で設立し、情報漏洩防止や正答率向上を目指します。

具体的には全社員が利用できる運用体制を整え、資料作成や翻訳などに活用。伊藤忠商事の事業のであるコンビニのファミリーマートや「ほけんの窓口グループ」など消費者向け事業にも展開し、新たな事業創出を目指しているそうです。

GPT-4o、朝は使えなかったけど、いまは使えるようになってた。無料アカウントで。画像認識とカロリー計算やってくれた。精度はまずます。黄身がひとつ壊れてるけど卵2個と認識した。pic.twitter.com/4x8Tn3Jjip

— 尻P(野尻抱介) (@nojiri_h)May 14, 2024

ChatGPT-4oは、無料プランと3000円(20ドル)の有料プラン、2種類が提供されています。それぞれのプランで利用できる機能や範囲が異なるため、自身のニーズに合わせて適切なプランを選択することが重要です。

| 機能 | 無料プラン | ChatGPT Plus |

|---|---|---|

| プログラミングコード生成 | JavaScript、Pythonなど基本的なものは可能 | 雑なアルゴリズムの実装や大規模なプログラムの作成まで可能 |

| 画像認識 | 可能 | 可能 |

| 音声入力 | 可能 | 可能 |

| データ分析 | 不可能 | 可能 |

| Webへのアクセス | 可能 | 可能 |

| 会話回数の制限 | 10回/1時間 | 無制限 |

| 応答速度 | 普通 | 高速 |

| 新機能へのアクセス | 不可能 | 可能 |

従来までは、GPT-4は無料ユーザーには一切アクセスすることができない機能でしたが、GPT-4oのリリースに伴って、回数制限付きで課金していなくてもGPT‐4oの基本的な機能を使えるようになっています。ただし、一部機能に制限があり、制限なく全機能を使いたい場合には課金が必要です。

| 音声出入力機能 | 音声での出入力はできるが、GPT-4oに実装されている高速でのやり取りにはアクセスできない。 |

| データ分析機能 | Googleドライブや、MicrosoftOneドライブから直接データを分析できる機能は使えない。 |

| 回数制限 | 会話の回数(トークン)に制限があり、現時点では10回使うと1時間GPT-4oにアクセスできなくなる。 |

| GPTストア、GPTs | 現時点では利用不可だが、近日中にアクセスできるようになるとの噂も。 |

| 画像・PDFのアップロード | 3枚または3ファイルまで。使い切ると15分の利用制限。 |

有料プラン「ChatGPT Plus」に加入すると、無料プランの制限が解除され、全ての機能を無制限に利用できるようになります。

また、新機能への優先アクセスや応答速度の向上など、様々な特典も受けられます。以下にその加入ステップをまとめました。

まずは画面左下の設定からUpgrade your planを選択

支払いはクレジットカードのみ。支払うと自動的にアップグレードされます

OpenAIの最新情報によると、ChatGPT-4oのAPIは、Chat Completions API、Assistants API、Batch APIで利用可能です。テキストだけでなく、画像も扱えるようになりました。

| 高知能化 | テキスト、推論、コーディング能力がGPT-4 Turboと同等以上。多言語、音声、視覚能力もさらに向上。 |

| 2倍の反応速度 | GPT-4 Turboと比べて、トークン生成速度が2倍に。 |

| 50%安い価格 | 入力トークンと出力トークンの両方で、GPT-4 Turboより50%安価。 |

| 5倍高いレート制限 | GPT-4 Turboと比べてレート制限が5倍になり、毎分最大1000万トークンまで処理可能。 |

| 視覚能力の改善 | ほとんどのタスクで視覚能力が向上。 |

| 非英語言語の能力の改善 | 非英語言語の処理能力が向上し、新しいトークナイザーで非英語テキストをより効率的に処理。 |

ただ、詳しい料金や利用体系は個別に問い合わせる必要があるので、もしAPIを利用してみたい方は以下のリンクより公式にアクセスしてみてくださいね。

ChatGPT-4oの無料プランは、ChatGPT-4oを試してみたい方や、基本的な機能のみを利用したい方におすすめです。一方、ChatGPT-4oを頻繁に利用したり、高度な機能を活用したい場合は、ChatGPT Plusへの加入を検討すると良いでしょう。

ビジネス用途でChatGPT-4oを利用する場合は、APIの利用がおすすめです。APIを利用することで、自社のシステムやアプリケーションにChatGPT-4oの機能を組み込み、カスタマイズすることができます。

自身の利用目的や予算に合わせて、最適なプランを選択しましょう。